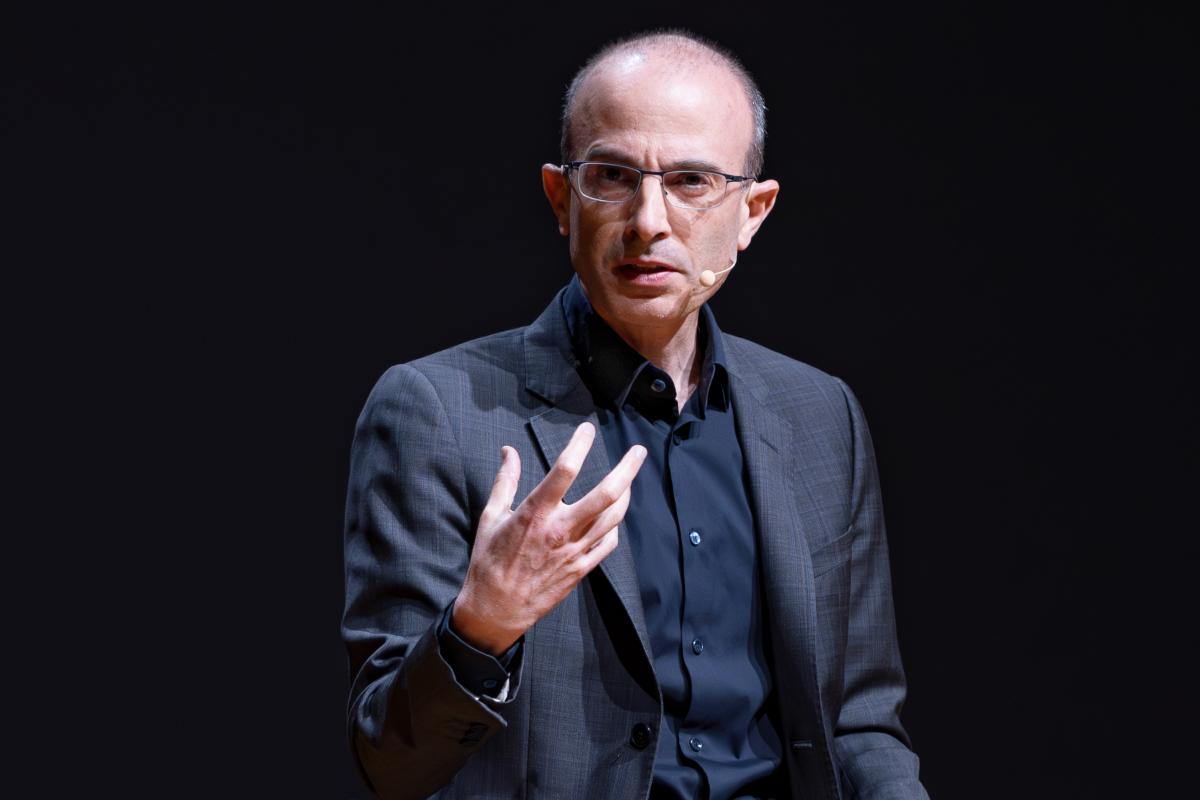

Harari en Davos 2026.

| Harari |

Cuando Yuval Noah Harari subió al escenario de Davos a mediados de 2026, parecía tener una misión clara: convencer a los líderes del mundo de que nuestra obsolescencia era inminente e inevitable. Lo logró. Durante 20 minutos tejió una narrativa apocalíptica donde las inteligencias artificiales “dominarían” el lenguaje, “conquistarían” la religión, y nos reducirían a caballos observando transacciones que ya no podemos comprender (si viste la conferencia comprenderás esta alusión). El problema no es que Harari esté preocupado por la IA. El problema es que todo su análisis descansa sobre proyecciones simbólicas que nunca examina, oculta relaciones de poder que deberían ser centrales, y termina ofreciendo exactamente lo que no necesitamos: pánico sin herramientas.

Puedes ver la conferencia completa aquí:

Desde la postmitología (un marco donde pensamos la relación humano-IA desde perspectiva simbólica y cultural) el discurso de Harari es un manual perfecto de cómo NO analizar la inteligencia artificial. Lo irónico es que cae precisamente en la trampa que hace que la IA parezca amenazante: proyecta sobre los sistemas técnicos propiedades que no tienen (agencia, intencionalidad, voluntad), naturaliza esas proyecciones como si fueran características del sistema, y construye una crisis existencial humana sobre esa proyección no examinada.

Primera capa: El cuchillo que decide

La piedra angular del argumento de Harari aparece en los primeros minutos (y ha sido la cita más publicitada):

“Lo más importante que hay que saber sobre la IA es que no es solo otra herramienta. Es un agente. Puede aprender y cambiar por sí misma, y tomar decisiones por sí misma. Un cuchillo es una herramienta. La IA es un ‘cuchillo’ que puede decidir por sí misma si corta ensalada o comete un asesinato.”Esta metáfora es técnicamente inexacta y simbólicamente peligrosa. Los sistemas de IA generativa operan mediante predicción probabilística: dado un contexto, predicen qué token viene después. No hay un “sujeto” que “decida” entre ensalada y asesinato. Hay arquitecturas de optimización que generan outputs según patrones estadísticos aprendidos de datasets masivos (algo que no es desconocido para él, pues lo documenta en sus libros “Homo Deus” y “Nexus” con respecto a las redes sociales).

Cuando Harari dice “la IA puede decidir”, está proyectando intencionalidad moral sobre procesamiento estadístico (cosa que probablemente haría estallar de rabia a Ramón López de Mántaras, destacado pionero de la IA en Europa). Esto es lo que en la postmitología llamamos la proyección del Oráculo de Código: atribuir a sistemas técnicos la capacidad de tomar decisiones con peso ético, como si tuvieran interioridad, biografía, responsabilidad.

¿Por qué importa? Porque si la IA es “agente autónomo”, entonces la responsabilidad se diluye. Cuando un sistema discrimina o genera contenido dañino, la narrativa del “agente” permite decir: “La IA decidió eso, no nosotros”.En mayo de 2023, el abogado Steven Schwartz enfrentó sanciones en una corte federal porque usó ChatGPT para investigación legal y citó seis casos de jurisprudencia completamente fabricados. Los precedentes tenían nombres convincentes, números plausibles. Pero ninguno existía. ¿Quién fue responsable? Schwartz tuvo que asumirlo porque él—no el sistema—presentó la información. No hay agente. Hay decisiones humanas específicas: qué datasets usar, qué métricas optimizar, qué interfaces diseñar. OpenAI decidió no incluir mecanismos de verificación robustos porque eso ralentizaría las respuestas. Decidió optimizar para lograr fluidez sobre exactitud. Decidió presentar información sin indicadores de incertidumbre porque maximiza sensación de autoridad.

Tratar a la IA como “agente” oculta precisamente eso: la cadena de decisiones humanas que produce cada output.

Segunda capa: Pensar no es procesar palabras

El segundo movimiento de Harari es más sutil:

“Si pensar realmente significa poner palabras y otros ‘tokens’ de lenguaje en orden, entonces la IA ya puede pensar mucho mejor que muchos humanos.”

Aquí Harari plantea una pregunta (”¿qué es pensar?”), ofrece una respuesta reduccionista (”ordenar palabras”), y concluye que la IA ya nos superó. El problema es que esa respuesta es falsa.

Pensar no es solo ordenar tokens. Es también experiencia corporal (el pensamiento enraizado en sensaciones, emociones), biografía y continuidad narrativa (pensamos desde una historia vivida), capacidad de responsabilizarse (sostener posiciones a través del tiempo), y dimensión ética irreducible (evaluar, juzgar, elegir según valores).

Harari casi llega a esta distinción cuando habla de “sentimientos no verbales”, pero inmediatamente la colapsa diciendo que “quizá hemos llegado al final del camino de las palabras”. Esto es una rendición prematura: confunde una capacidad técnica impresionante (generar texto fluido) con la totalidad del pensamiento humano.

¿Por qué colapsa Harari esta distinción? Porque necesita establecer que la IA es superior en “nuestro dominio” para construir su narrativa de obsolescencia. Si admitiera que el pensamiento humano incluye dimensiones que ningún modelo probabilístico puede replicar—no por limitación tecnológica sino por diferencia estructural—su argumento perdería fuerza.

La consecuencia práctica: si aceptamos que “pensar = ordenar palabras”, justificamos la delegación masiva de funciones cognitivas críticas a sistemas que no pueden responsabilizarse por sus outputs.

Tercera capa: El error político-estructural

Luego Harari hace algo extraordinario: compara la llegada de la IA con una “crisis migratoria” donde “millones de IAs” serían los nuevos “inmigrantes” que quitan trabajos y cambian la cultura.

Esta metáfora no es inocente. Es instrumentalización de ansiedades xenofóbicas para generar rechazo tecnológico. Las IAs no “migran”, no tienen nacionalidad, no “cruzan fronteras”. Son sistemas desplegados por corporaciones específicas bajo decisiones específicas. Harari menciona brevemente que serán “leales a corporaciones en China o Estados Unidos”, pero esto debería ser el análisis central, no comentario lateral.

Porque aquí está el error estructural más grave: su análisis es puramente dualista (Humanos vs. IA) cuando debería ser triádico. La postmitología propone que toda interacción ocurre en tres dimensiones: humana (psique, proyecciones), técnica (arquitectura, algoritmos), y sociotécnica (plataformas, infraestructura, poder).

Harari habla casi exclusivamente de las dos primeras. La tercera (la matriz de poder que sostiene todo) está casi ausente. No menciona (y aquí te recomendamos leer el “Atlas de Inteligencia Artificial” de Kate Crawford):

- Que entrenar GPT-3 consumió 1,287 MWh, equivalente al consumo anual de 120 hogares estadounidenses

- Que cada interacción depende de trabajo humano precarizado. Para que ChatGPT no genere contenido violento, OpenAI contrató trabajadores en Kenia pagándoles $1.32-$2 por hora para revisar contenido traumático: violaciones, asesinatos, abuso infantil. Estos trabajadores reportaron estrés postraumático severo. Sin ese trabajo invisible, la IA “limpia” no existiría

- Que la extracción de litio y cobalto desplaza comunidades en Chile, Argentina, Congo

- Que las decisiones de diseño de interfaces maximizan deliberadamente proyección de autoridad

- Que la opacidad de modelos propietarios impide auditoría pública

Y qué irónico que esto ocurra en Davos, donde se reúnen precisamente las élites—CEOs de corporaciones tecnológicas, jefes de estado, inversores—que diseñan, financian y despliegan los sistemas que Harari presenta como “fuerzas inevitables”. Davos no es escenario neutral: es donde el capitalismo tecnológico se legitima discursivamente mientras consolida poder materialmente.

Presentar la IA como “fuerza autónoma inevitable” oculta que es producto de decisiones humanas específicas tomadas por actores con intereses económicos y políticos concretos.

Cuarta capa: Pánico sin herramientas

El error pragmático final: Harari no ofrece absolutamente nada para navegar la situación que describe. Su discurso termina: “Si quieres influir en hacia dónde va la humanidad, necesitas decidir ahora. ¿Qué harás?”

Esto es pregunta imposible sin equipamiento. Es describir un incendio y preguntar “¿qué harás?” sin proporcionar extintores, rutas de evacuación, o teléfono de bomberos.

La postmitología no solo diagnostica, intenta equipar, y ofrecer protocolos (si has leído algunos de nuestros artículos te darás cuenta) para trabajar conscientemente con las proyecciones simbólicas que depositamos sobre la IA.

Las preguntas que Harari no hizo

Harari pregunta: “¿Reconocerás a las IAs como personas jurídicas?”

En realidad debió preguntar:

- ¿Quién controla la infraestructura que hace posible estos sistemas?

- ¿Cómo se distribuyen los beneficios económicos del deployment masivo?

- ¿Quién asume los costos cuando los sistemas fallan o discriminan?

- ¿Qué decisiones de diseño maximizan proyección de agencia, y con qué propósitos?

- ¿Cómo mantenemos agencia simbólica cuando interactuamos con sistemas que dominan el lenguaje (el medio donde nos constituimos como sujetos) sin habitarlo?

Estas preguntas ponen el foco donde debe estar: no en “la IA como agente autónomo” sino en las relaciones de poder humanas que producen, diseñan, despliegan y regulan estos sistemas.Porque el problema no es la IA.

El problema es cómo (no) la pensamos, cómo (no) nombramos las proyecciones que depositamos sobre ella, cómo (no) visibilizamos las relaciones de poder que la producen, y cómo (no) nos equipamos para habitarla conscientemente.

Harari nos mostró en Davos cómo NO hacerlo.

Ahora toca construir las alternativas.

Christian Rodway, El problema no es la IA: es cómo Harari la piensa, Explorando la Zona Híbrida 29/01/2026

Comentaris